回想起上次仔细看transformer还是上次,现在遗忘得又有点多了,从原理到代码重新过一遍,于是就有了这篇博客~

2024-12-23

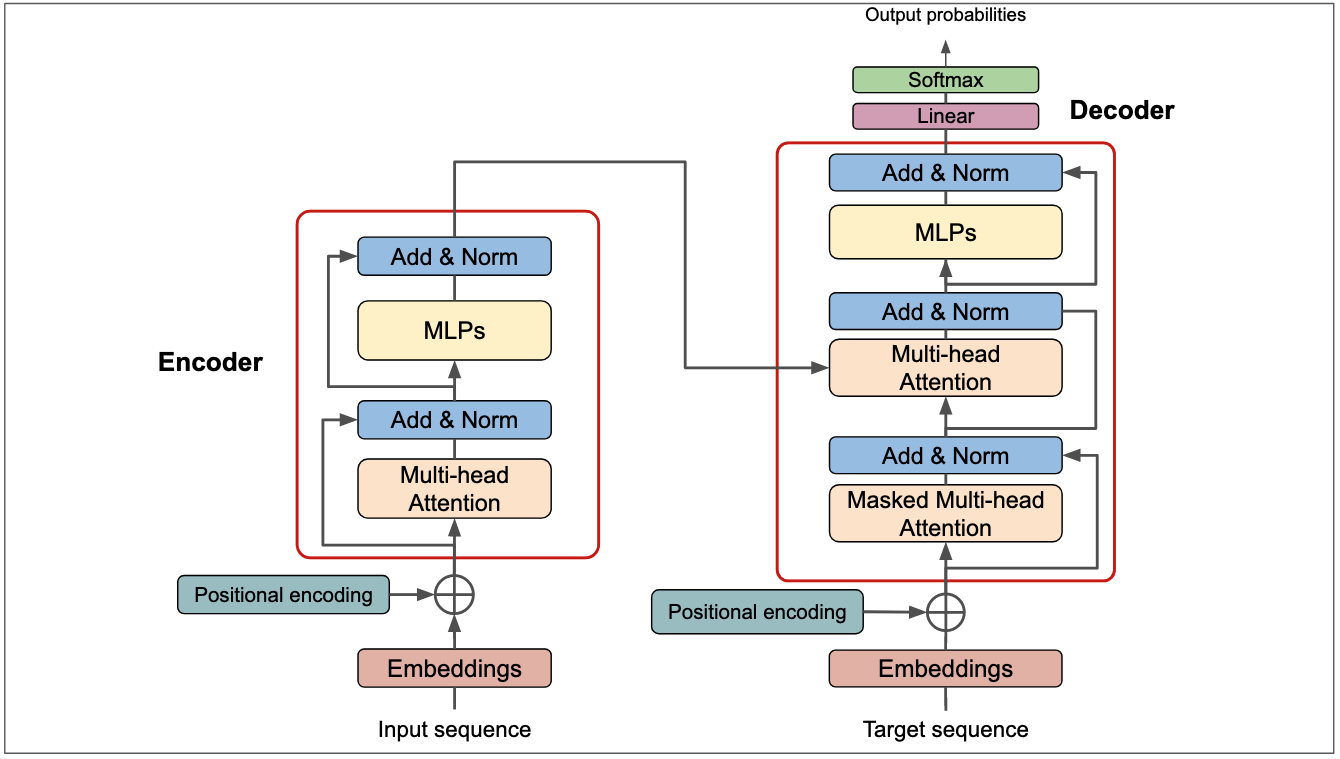

【学习】Transformer基础架构

【学习】Transformer基础架构

“视界感知者”项目开发文档

“视界感知者”项目开发文档

Patch-level Routing in MOE:针对局部图像区域分配专家,提高样本效率

Patch-level Routing in MOE:针对局部图像区域分配专家,提高样本效率

MOELoRA: 一种基于MOE多任务医疗应用下的高效参数微调方法

MOELoRA: 一种基于MOE多任务医疗应用下的高效参数微调方法

MOE混合专家模型架构

MOE混合专家模型架构

LoRA微调原理

LoRA微调原理

水手与海

水手与海

NovelAI生成绘画素材

NovelAI生成绘画素材

在Linux服务器上升级Python版本

在Linux服务器上升级Python版本

2024-新春寄语

2024-新春寄语

トレイル(小径)

トレイル(小径)

写在前面

写在前面